Tercer Milenio

En colaboración con ITA

Computación: superordenadores un millón de veces más potentes

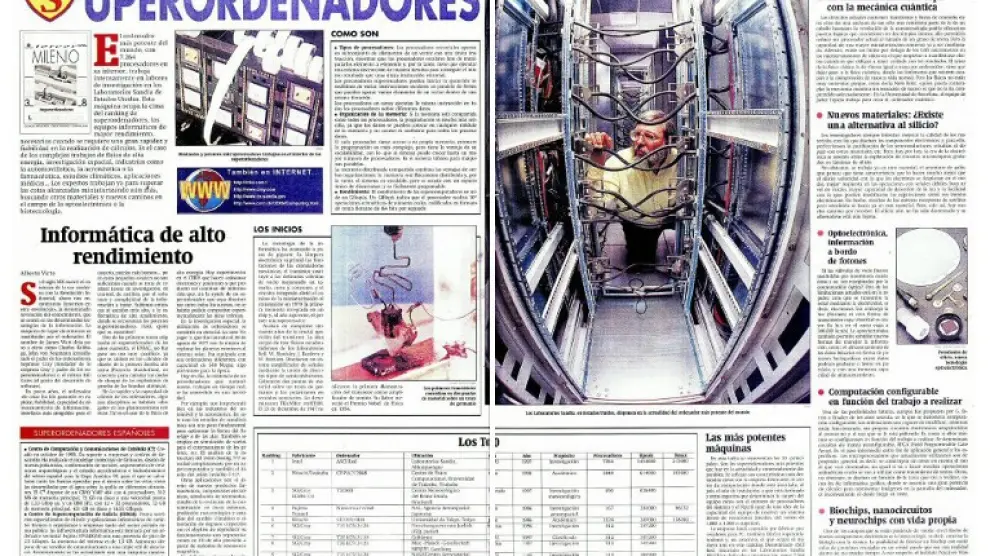

Las omnipresentes Tecnologías de la Información y la Comunicación (TIC) se levantan sobre la creciente capacidad de los ordenadores de generar, almacenar, transmitir y calcular enormes volúmenes de información. En las últimas décadas, los ordenadores han pasado a ser superordenadores cada vez más potentes, como el Mare Nostrum del Barcelona Supercomputing Center que dirige el aragonés Mateo Valero. De su mano ascendemos la escalera que hace estas máquinas cada vez más poderosas.

Desde el corazón del centro pionero de la supercomputación en España, el Barcelona Supercomputing Center (BSC), su director, Mateo Valero, hace balance: "Durante los últimos 25 años ha habido una mejora espectacular de las capacidades de generar, almacenar, transmitir y calcular enormes cantidades de información binaria. Estos son los pilares de las TIC, en los que se sustentan fenómenos que están cambiando toda la sociedad, como internet, la inteligencia artificial, la medicina personalizada, los coches autónomos". En el caso de la supercomputación, "en 25 años la potencia de un superordenador se ha multiplicado por un millón".

Esto supone generar y procesar toneladas de datos. "Se calcula que en 2020 habrá más de 40.000 millones de dispositivos conectados y se generarán más de 50 Zetabytes (1021 bytes) de información, de los que una décima parte se transmitirá por internet", señala Valero. Para hacernos una idea, lo mejor es contemplar una comparación impresionante: solo a lo largo de este año "se generará casi tanta información como todos los años anteriores de la humanidad".

¿Nos desborda este caudal de información? "La generación de datos y el movimiento de muchos de esos datos a través de internet crece casi de manera exponencial. Tenemos capacidad para generarlos, almacenarlos y enviarlos. La pregunta es: ¿tenemos capacidad para obtener conocimiento de esos datos?, ¿tenemos leyes adecuadas que nos protejan de su mal uso?, ¿está el poder económico del mundo en manos de unos pocos?, ¿cambiará totalmente la economía de los países?...", se pregunta Mateo Valero.

En todos los campos

Los supercomputadores como el Mare Nostrum del BSC se utilizan, por ejemplo, para diseñar mejores aviones y coches, para encontrar nuevos fármacos que curen enfermedades como el cáncer y el sida, para estudiar el cambio climático, la calidad del aire de las ciudades y buscar petróleo de manera más eficiente.

La computación de altas prestaciones genera modelos que simulan la realidad, o lo intentan, porque "simular, podemos simular todo aquello que se pueda caracterizar por fórmulas matemáticas". La simulación clásica "se basa en usar y programar las leyes físicas y químicas de los fenómenos para simular diferentes escenarios, pero la pregunta es "si tenemos modelos adecuados y si la velocidad de los supercomputadores nos permite obtener resultados aceptables en tiempo razonable. Cada vez que se construyen computadores más rápidos y con memorias más grandes, los investigadores hacen modelos más cercanos a la realidad". Así, "los futuros supercomputadores Exascale (1018 operaciones por segundo, y construidos con más de 100 millones de procesadores), que serán una realidad en menos de cuatro años, podrán mejorar la ejecución de modelos actuales para producir resultados que estén mucho más cerca de la realidad".

Inteligencia artificial y 'machine learning'

Para el investigador aragonés, "en la simulación clásica, el programa expresa todas las operaciones que hay que hacer con los datos. En cierta manera, son programas deterministas". Ahora, con la inteligencia artificial, explica, "está cambiando un poco el método de simular en algunas aplicaciones. Existen aplicaciones en las que se definen ciertos objetivos a alcanzar y los programas, analizando los datos que tienen, deciden cómo continuar hasta dar con la solución. Son técnicas de 'machine learning' que están permitiendo resolver problemas muy difíciles de tratar con la simulación clásica". De hecho, "los supercomputadores actuales ya y los del futuro tendrán programas donde se mezclarán las simulaciones clásicas y avanzadas y se construirán con hardware optimizado para ejecutar de manera eficiente los dos tipos de programa". De esta forma, simulación clásica e inteligencia artificial cooperarán en el interior de los superordenadores dentro de muy poco.

"La reducción en el tamaño de los transistores ha sido una realidad durante muchos años explica Mateo Valero. Se cree que llegaremos a diseñar transistores de 7 o hasta 5 nanómetros, pero no iremos más allá por la aparición de fenómenos cuánticos, como el efecto túnel de los transistores". ¿Qué vendrá después?. "Se está investigando en hacer transistores en tres dimensiones y usando nuevos componentes como grafeno para seguir ganando algo de velocidad". Desde hace unos años, "también se están diseñando procesadores específicos, por ejemplo, los dedicados a la inteligencia artificial, que permiten ejecutar algunas aplicaciones de manera mucho más rápida". Por otra parte, "se habla de nuevas formas de hacer computadores y la más comentada son los computadores cuánticos. Se cree que resolverán algunas aplicaciones como las de optimización de manera mucho más rápida que los computadores tradicionales, pero nunca los sustituirán".

-Ir a Tercer Milenio